En julio de 2021, el Parlamento Europeo adoptó la propuesta de la Comisión Europea para permitir el escaneo general e indiscriminado de mensajes privados y fotos de los usuarios (control de chat).

La ley se presentó como una derogación temporal de las reglas de privacidad de la UE, que permitiría, no obligaría, a los proveedores de mensajería a escanear los mensajes. Sin embargo, tras la votación del Parlamento, la Comisión Europea no tardó en preparar Chat control 2.0, una propuesta que haría obligatorio el escaneado general e indiscriminado de nuestras fotos y mensajes.

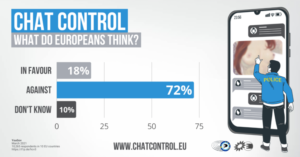

La idea ya ha recibido el apoyo entusiasta de muchos ministros del interior de la UE, pero no tuvo tan buena acogida por parte de los ciudadanos ni de los eurodiputados. Una gran mayoría de los ciudadanos de la UE (72%) se oponen a la mensajería general y al control del chat, según una encuesta de opinión realizada por YouGov entre 10 265 ciudadanos de 10 países de la UE.

A pesar de los comentarios abrumadoramente negativos en una consulta pública, así como de una carta de eurodiputados que expresan serias reservas sobre la propuesta, la Comisión ha seguido adelante.

Este enfoque alcista no es nada nuevo: apresuraron el control de Chat 1.0 sin siquiera consultar a los ciudadanos, empresas u ONG. No preguntaron a los ciudadanos si querían controlar el chat, y no preguntaron a las ONG si realmente ayudaría a resolver el problema para el que fue creado.

Una pesadilla para nuestra privacidad

Si bien Chat control 1.0 ya tiene el potencial de poner fin de facto a la privacidad de la correspondencia en la Unión Europea, solo lo implementan proveedores estadounidenses como Meta, Google y Microsoft. Chat control 2.0 va un paso más allá al exigir la vigilancia general e indiscriminada de todas nuestras conversaciones, utilizando cualquier proveedor de servicios.

La Comisión no dice cómo los proveedores deben implementar la detección, especialmente considerando que muchas aplicaciones de mensajería ahora usan encriptación de extremo a extremo, lo que significa que es imposible que los proveedores de mensajería lean nuestros mensajes, pero las pocas ideas que han surgido hasta ahora tienen mucho. -llegando a implicaciones para nuestra privacidad.

Romper el cifrado

Una propuesta popular entre algunos estados miembros es romper el cifrado de extremo a extremo en la Unión Europea, ya sea obligando a los proveedores a almacenar copias de las claves de cifrado de los usuarios o utilizando una «clave maestra» para los clientes de la UE que permitirá descifrado de conversaciones.

Estas propuestas allanan el camino para el abuso por parte de las autoridades en los estados miembros, por ejemplo, al escanear contenido más allá de los límites establecidos por la regulación, o al desarrollar una vigilancia masiva de comunicaciones cifradas. Incluso si la propuesta contuviera límites sobre qué usos de estas claves son aceptables, sería imposible garantizar que estos límites se respeten, especialmente teniendo en cuenta las dificultades existentes para hacer cumplir el estado de derecho en la UE, el hecho de que la Comisión ha ninguna competencia con respecto a la seguridad nacional, y el hecho de que los programas previos de vigilancia masiva han evadido la supervisión.

Peor aún, si los gobiernos extranjeros o los piratas informáticos obtuvieran las claves, podrían espiar a todos los ciudadanos de la UE, incluidos legisladores, periodistas, psicólogos y médicos, activistas y ciudadanos comunes que confían en el cifrado de extremo a extremo para proteger sus conversaciones.

Uso de IA para buscar material «desconocido»

Otro enfoque que la Comisión está explorando es el uso de IA propensa a errores para buscar contenido ilegal. Aquí, la Comisión ha caído en la trampa de creer que la IA es una “bala mágica” que puede resolver cualquier problema. No lo es.

La inteligencia artificial busca patrones, pero no comprende el contexto, lo que significa que una plétora de mensajes, desde fotos de vacaciones hasta sexts, se marcarán incorrectamente. Peor aún, las IA con frecuencia tienen problemas para identificar correctamente la edad de las personas en las fotos, especialmente cuando esas personas pertenecen a grupos minoritarios (minorías étnicas, LGBTQI, personas con discapacidades).

Como resultado, las imágenes o conversaciones marcadas por AI requieren verificación humana, lo que significa que sus fotos o videos íntimos y personales pueden terminar en manos de contratistas o personal global donde no están seguros. Si pareces más joven de lo que eres, o si perteneces a uno de estos grupos, es probable que las conversaciones privadas e incluso tus desnudos terminen en manos de las fuerzas del orden. Para empeorar las cosas, hay muchos ejemplos de agencias policiales y de inteligencia que copian o comparten fotos de desnudos que obtuvieron como parte de investigaciones con sus colegas y terceros.

Escaneo del lado del cliente con hashes

Los expertos sugieren convertir nuestro teléfono móvil en un dispositivo de vigilancia: antes de cifrar y enviar un mensaje, su teléfono buscará fotos y videos que coincidan con el material de la lista negra. Si el algoritmo informa un acierto, su mensaje privado, foto y/o video se informarán y divulgarán automáticamente al proveedor y/o a la policía.

Según la Policía Federal Suiza, el 86% de los informes de material incluido en la lista negra no tienen relevancia penal. La base de datos no transparente de material incluido en la lista negra contiene una gran cantidad de fotos y videos que no son relevantes desde el punto de vista penal (por ejemplo, niños jugando en la playa) y aún así lo denunciarán a la policía por supuesta «pornografía infantil». Incluso si es inocente, la investigación puede dar lugar a interrogatorios, registros domiciliarios, confiscación. También una gran parte de las investigaciones se dirigen a menores de edad, los niños a los que se pretende proteger.

Lo que es más importante, dicha vigilancia en el dispositivo socavaría la confianza en la privacidad y la seguridad de las comunicaciones confidenciales, interrumpiendo las actividades, por ejemplo, de los denunciantes, los defensores de los derechos humanos, los activistas a favor de la democracia, los periodistas en muchos países. Los expertos advierten que una vez que nuestros teléfonos móviles se han convertido en errores, es solo un pequeño paso para expandir el sistema a presuntas violaciones de derechos de autor, terrorismo o disidencia política. Los gobiernos también pueden utilizar estas puertas traseras para interceptar subrepticiamente el contenido de la correspondencia confidencial que se cree que está encriptada de forma segura de extremo a extremo.

¿Ineficaz y contraproducente?

También hay un conjunto más amplio de problemas que hacen que Chat control 2.0 sea contraproducente:

En primer lugar, las autoridades tendrían que concentrar sus recursos limitados en tratar los casos señalados por el sistema, lo que probablemente incluiría una avalancha de falsos positivos. Tendrán aún menos tiempo para investigar casos de abuso.

Peor aún, la ley también haría más difícil atrapar y enjuiciar a los delincuentes sexuales. Esta propuesta empujaría a más delincuentes a la red oscura, a sitios web ocultos e imposibles de rastrear, lo que haría imposible atrapar a los cómplices.

¿Una pendiente resbaladiza?

Mientras que Chat control 1.0 ya nos pone en un camino peligroso, Chat control 2.0 nos pone en una pendiente resbaladiza: simplemente dar a los gobiernos la posibilidad de escanear nuestras conversaciones y fotos, incluso en una escala limitada, invitaría abiertamente al abuso: una vez que los gobiernos tengan la medios para escanear mensajes como parte de la ley de la UE, pueden expandir el escaneo a través de la ley nacional bajo el pretexto de «Seguridad Nacional», un área en la que la Unión Europea no tiene poderes.